De bedrijfsjurist en de AI Act: genoeg te doen!

Door de NGB Werkgroep Digitalisering, op voorzet van mr. Mariëlle Trimbos-Hartman, advocaat in dienstbetrekking bij Stedin Groep. Met medewerking van:

- mr. Vincent Roos (Halsten);

- mr. Lisette Guineé (Randstad);

- mr. Momet Abas (DXC);

- mr. Martin Woodward (Arcadis);

- mr. Marjon Vloedbeld (Textkernel);

- Aart Jan Zwartscholten,Lead Digital Innovation & AI bij Stedin Groep.

Wie had ooit gedacht dat kunstmatige intelligentie (in het Engels artificial intelligence, afgekort ’AI‘) nu al in zoveel sectoren in onze samenleving een rol zou vervullen? Inmiddels kijken we niet meer op van verschijnselen zoals een virtuele assistent op je telefoon, deep fake video’s, AI-generated NFT’s, zelfrijdende auto’s, data-gedreven overheidsbesluitvorming en voorspellende onderhoudsapplicaties. De technologische ontwikkelingen gaan zó snel, dat er behoefte is ontstaan om dit door middel van regelgeving in goede banen te leiden. Want het gebruik van kunstmatige intelligentie kan ook risico’s met zich brengen, denk aan het gebruik van war drones[ii] of deep fake telefoongesprekken[iii]. Naast al bestaande initiatieven vanuit publiek-private samenwerkingen, zoals de Artificial Intelligence Impact Assessment vanuit het onafhankelijke ECP Platform voor de InformatieSamenleving[iv], ontstaat nu ook op Europees niveau een juridisch kader.

Marielle Trimbos-Hartman

’Just as electricity transformed almost everything 100 years ago, today I actually have a hard time thinking of an industry that I don’t think AI will transform in the next several years.’

Andrew Ng”[i]

Op 21 april 2021 is het voorstel gepubliceerd voor een Europese verordening tot vaststelling van geharmoniseerde regels betreffende artificiële intelligentie (hierna: het “Voorstel”)[v]. Het doel van dit Voorstel is onder meer om bestaande wetgeving op dit vlak te verbeteren en om in Europa rechtszekerheid en rechtseenheid te creëren, zodat het investeren in (de innovatie van) AI aantrekkelijker wordt. Ook moet de toekomstige verordening ervoor zorgen dat de artificiële intelligentie-systemen die in de Europese Unie in de handel worden gebracht en gebruikt, veilig zijn voor de Europese burger[vi]. Op dit moment wordt het wetgevingsproces doorlopen. Dat duurt door het veelvoud aan compromisvoorstellen en amendementen mogelijk langer dan verwacht. Het Tsjechische voorzitterschap in de Raad probeert eind december 2022 een algemene oriëntatie op de AI Act te bereiken.

Aanpak van het Voorstel

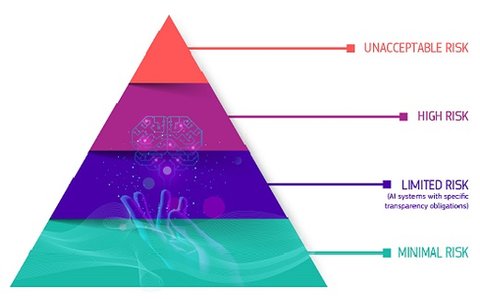

In het Voorstel is gekozen voor een risicogebaseerde regelgevingsaanpak. Hoe groter het risico voor grondrechten en veiligheid, hoe meer verplichtingen moeten worden nageleefd.

AI-systeem

Het kernbegrip in dit Voorstel is de term AI-systeem, waarmee software bedoeld wordt waarmee bijvoorbeeld voorspellingen en aanbevelingen kunnen worden gedaan of beslissingen kunnen worden genomen. De reikwijdte van dit begrip is breed, ook een ‘slimme’ Excel sheet zou onder de definitie van AI-systeem kunnen vallen[vii]. Er bestaat dan ook veel kritiek op de reikwijdte van het Voorstel (verderop in dit artikel wordt besproken welke voorstellen tot wijziging inmiddels zijn gedaan). De ruime scope en werking (het Voorstel geldt ook voor bedrijven buiten Europa die bij het op de Europese markt brengen van hun product gegevens van Europeanen verwerken met behulp van een AI-systeem) en het groot aantal verplichtingen zal voor veel ondernemingen een flinke investering betekenen[viii]. Omdat het Voorstel spreekt van voortdurende verplichtingen, zullen de investeringen van ondernemingen geen eenmalig karakter hebben. Het Voorstel houdt daarbij gelukkig wel rekening met kleine aanbieders en startups.

Voorschriften van risicobeheer en monitoring

In het Voorstel is opgenomen dat voor bepaalde AI-systemen, namelijk AI-systemen met een hoog risico, een tijdens de levensduur voortdurend systeem van risicobeheer en monitoring verplicht is, dat steeds actualisering vereist. Zo moet bij iedere wijziging de bij de software verplicht aanwezige technische documentatie worden aangepast. In de technische documentatie staat een waslijst aan informatie die doet denken aan de bijsluiter van een medicijn. Niet alleen moet er een gebruiksaanwijzing en een installatie-instructie worden opgenomen, maar onder andere ook ontwerpspecificaties, ontwerpkeuzen, een beschrijving van de systeemarchitectuur en de gebruikte validatie- en testprocedures behoren tot de verplichte onderdelen van de technische documentatie. Vanwege deze uitgebreide voorschriften ligt het voor de hand dat organisaties een AI-functionaris zullen aanstellen om de correcte naleving van de complexe regels te kunnen garanderen, vergelijkbaar met de functionaris gegevensbescherming ingevolge de AVG[ix]. Gezien de veelheid aan Europese regelgeving op het gebied van data en ICT zou de rol van een AI-functionaris gecombineerd kunnen worden met werkzaamheden die uit die EU-regelgeving (onder meer richtlijn open data (2019), data-governance verordening (2020), dataverordening, digital services act en digital markets act (2022)) voortvloeien. De samenhang tussen deze regelingen blijkt onder meer uit de toelichting op het Voorstel: De bevordering van AI-gestuurde innovatie is nauw verbonden met de EU-datastrategie voor ’betrouwbare mechanismen en diensten om data die essentieel zijn voor de ontwikkeling van kwalitatief hoogstaande, data-gestuurde AI-modellen te hergebruiken, te delen en te bundelen.’

Heeft de bedrijfsjurist een rol bij de implementatie?

In dit artikel wordt niet beoogd een volledig beeld te schetsen van de inhoud van het Voorstel en de voorgestelde wijzigingen daarop. Wel wordt vanuit de positie van een bedrijfsjurist bekeken wat de rol van die bedrijfsjurist kan zijn bij de voorbereiding van de implementatie van de bepalingen van het Voorstel in de onderneming waar de bedrijfsjurist werkt. Dat zal per onderneming verschillen vanwege de verscheidenheid aan soorten Juridische Afdelingen binnen ondernemingen en vanwege de aard van de onderneming (ontwikkelaar van AI-systemen of alleen gebruiker). Vanzelfsprekend kan de volledige voorbereiding worden uitbesteed. Maar gezien het feit dat AI-systemen diep kunnen ingrijpen in besluitvormingsprocedures en de technische processen binnen een onderneming en de rol van AI binnen bedrijven steeds meer toeneemt, is het raadzaam dat de bedrijfsjurist toch meedenkt over wat het inhoudt om te werken met AI-systemen, welke voorschriften van toepassing worden en misschien ook op welke wijze die voorschriften in de onderneming in processen omgezet kunnen worden. Juist ook bij de ethische vraagstukken kan de bedrijfsjurist van toegevoegde waarde zijn. Een voorbeeld dat heel goed past bij de taak van de bedrijfsjurist is het opstellen van een (vrijwillige) gedragscode in het geval dat er sprake is van een AI-systeem met een laag risico, zoals bijvoorbeeld een chatbot. Dit geldt des te meer wanneer de bedrijfsjurist ook de compliance officer is. Onderwerpen die in zo’n gedragscode naar voren kunnen komen zijn volgens het Voorstel onder meer milieuduurzaamheid, toegankelijkheid voor personen met een handicap, deelname van belanghebbenden aan het ontwerp en de ontwikkeling van AI-systemen en diversiteit van ontwikkelingsteams op basis van duidelijke doelstellingen en kernprestatie-indicatoren om de verwezenlijking van die doelstellingen te meten. Nog logischer (en efficiënter voor Nederlandse ondernemingen) is misschien dat er een landelijke of sectorale werkgroep[x] wordt opgericht om bedrijfsjuristen gezamenlijk te laten nadenken over een model voor zo’n gedragscode, dat voor ondernemingen algemeen beschikbaar kan worden gemaakt.

De veranderende rol van de bedrijfsjurist

De rol van bedrijfsjurist verandert steeds sneller. De AI Act kan aan die versnelling bijdragen. Van een bedrijfsjurist wordt verwacht dat deze een strategic trusted advisor is die het overzicht heeft over het juridisch speelveld van de onderneming en over nieuwe wetgeving die dat speelveld transformeert. Ook werken bedrijfsjuristen steeds vaker projectmatig in multidisciplinaire teams. De implementatie van dit Voorstel vergt een nauwe samenwerking tussen de bedrijfsjurist, de compliance officer, de IT-afdeling en de technische medewerkers van een onderneming. Twee voorbeelden:

Voorbeeld 1: Het Voorstel bevat een beschrijving van verboden praktijken op het gebied van kunstmatige intelligentie. Voor een deel richt dit onderdeel zich op overheidsinstanties, deels raakt het ook ondernemingen. Een bedrijfsjurist kan de onderneming adviseren wat wel en niet mag en wat in grijs gebied ligt. Zo is het bijvoorbeeld verboden om gebruik te maken van een AI-systeem dat gebruik maakt van kwetsbaarheden van een specifieke groep personen (bijvoorbeeld kinderen of ouderen) om het gedrag van personen die tot deze groep behoren, wezenlijk te verstoren op een wijze die er waarschijnlijk toe zal leiden dat deze of andere personen fysieke of psychologische schade oplopen. De bedrijfsjurist kan ook beoordelen wanneer sprake kan zijn van een wezenlijke verstoring als bedoeld in het Voorstel.

Voorbeeld 2: In het Voorstel wordt een onderscheid gemaakt naar AI-systemen met een:

- onaanvaardbaar risico;

- hoog risico;

- laag risico;

- minimaal risico.

De meeste aandacht gaat vanzelfsprekend uit naar de AI-systemen met een hoog risico. Bij AI-systemen met een hoog risico kan discriminatie een rol spelen. Onder meer AI-systemen die de overheid ondersteunt bij asielaanvragen, die profileren ten behoeve van rechtshandhavingsautoriteiten, die recidive-beoordelingen uitvoeren, die de kredietscore van natuurlijke personen vaststellen en AI-systemen die beoordelen of studenten toegelaten worden tot onderwijsinstellingen kunnen zogenoemde bias bevatten. De input voor de algoritmes is immers in de loop der tijd door mensen verzameld en iederéén heeft (al dan niet onbewust) door onder meer opvoeding en levenservaring vooroordelen. Het is voor een onderneming van belang dat bekend is tot welke categorie het AI-systeem behoort dat ontwikkeld wordt of waarvan gebruik wordt gemaakt in de onderneming. De bedrijfsjurist kan daarbij een ondersteunende rol spelen. Een medewerker van de onderneming kan waarschijnlijk goed uitleggen welke functie het AI-systeem heeft, van welke input het AI-systeem gebruik maakt en op welke wijze de output wordt gegenereerd (wat de criteria zijn om door het AI-systeem geselecteerd te worden, bijvoorbeeld). Met deze informatie kan de bedrijfsjurist aan de hand van de tekst van het Voorstel en de bijlagen beoordelen of dat specifieke AI-systeem moet worden gekwalificeerd als AI-systeem met een hoog risico. Vervolgens kan de bedrijfsjurist adviseren welke processen de onderneming moet inrichten om te voldoen aan de verordening. Zoals hiervoor al aangestipt, moet een onderneming in geval van een AI-systeem met een hoog risico bijvoorbeeld op grond van het Voorstel een systeem voor risicobeheer vaststellen, uitvoeren, documenteren en in stand houden. Het Voorstel vereist een periodieke systematische actualisering. Dit systeem voor risicobeheer houdt in dat bekende en te voorziene risico’s die gepaard gaan met elk AI-systeem met een hoog risico worden vastgesteld en geanalyseerd. Die risico’s worden vervolgens ingeschat en geëvalueerd. Het Voorstel vereist ook een evaluatie van risico’s die zich kunnen voordoen op basis van de analyse van de data die zijn verzameld door het systeem voor monitoring na het in de handel brengen van het AI-systeem en het vaststellen van geschikte risicobeheersingsmaatregelen. Op grond van het Voorstel moeten ondernemingen zichzelf de vraag stellen op welk moment het menselijk toezicht moet plaatsvinden en hoe dat er uit moet zien, in het kader van dataopschoning moet beoordeeld worden tot welke grens een uitschieter in de output van het AI-systeem aanvaardbaar is, hoe de relevante parameters in het ontwerp bepaald mogen worden en aannames en vooroordelen gefilterd worden. De bedrijfsjurist kan meedenken over die vragen en verder helpen bepalen welke informatie bewaard moet blijven en voor hoe lang. De nieuwe ISO-standaard 38507 kan daarbij behulpzaam zijn. Gezien al het voorgaande zal in de functieomschrijving van de AI-functionaris in plaats van ’een IT-er met een juridische achtergrond‘ waarschijnlijk eerder een ’jurist met technische kennis van AI-systemen‘ komen te staan.

Aanbieder of gebruiker?

De bedrijfsjurist kan niet alleen assisteren bij de vaststelling in welke risicocategorie het gebruikte of te ontwikkelen AI-systeem valt, maar ook hoe de onderneming moet worden gekwalificeerd. Het Voorstel bevat verstrekkende verplichtingen voor aanbieders van AI-systemen. Onder het begrip aanbieder wordt niet alleen iemand verstaan die een AI-systeem ontwikkelt maar ook iemand die beschikt over een AI-systeem dat is ontwikkeld met het oog op het al dan niet tegen betaling in de handel brengen of in gebruik stellen ervan onder de eigen naam of merknaam. Het Voorstel bevat ook verplichtingen voor gebruikers van AI-systemen met een hoog risico. Een (rechts)persoon valt overigens niet onder de term gebruiker als het AI-systeem wordt gebruikt in het kader van een persoonlijke niet-beroepsactiviteit. Het Voorstel somt de volgende verplichtingen voor gebruikers op:

- Een gebruiker gebruikt een AI-systeem met een hoog risico in overeenstemming met de gebruiksaanwijzing en neemt maatregelen om menselijk toezicht zoals aangegeven door de aanbieder uit te voeren.

- De inputdata dient relevant te zijn voor het beoogde doel van het AI-systeem met een hoog risico. Daarbij wordt wel de kanttekening gemaakt dat deze verplichting geldt voor zover de gebruiker de controle heeft over de inputdata. Dat zal niet altijd het geval zijn.

- De gebruiker monitort het AI-systeem en gebruikt de gebruiksaanwijzing daarbij als handleiding.

- Het gebruik van het AI-systeem met een hoog risico moet gestaakt worden als sprake is van een risico voor de gezondheid of veiligheid of voor de bescherming van grondrechten van personen.

- Dat geldt eveneens voor de situatie waarin sprake is van een ernstig incident of wanneer een gebrekkige werking is vastgesteld. De gebruiker meldt dit dan ook aan de aanbieder en/of distributeur.

- Gebruikers van AI-systemen met een hoog risico bewaren de logs die automatisch worden gegenereerd door deze AI-systemen. Ook hier wordt de kanttekening gemaakt dat deze verplichting slechts geldt voor zover dergelijke logs onder hun controle vallen. De logs worden bewaard gedurende een periode die passend is gezien het beoogde doel van het AI-systeem met een hoog risico en de toepasselijke wettelijke verplichtingen.

Het Voorstel noemt nog de mogelijkheid dat gebruikers soms als aanbieders kunnen worden aangemerkt, bijvoorbeeld wanneer de gebruiker een ingrijpende wijziging aanbrengt in het AI-systeem. Plotseling gelden dan alle verplichtingen voor aanbieders voor deze gebruiker. Het is dus zaak hiermee rekening te houden.

De EU-databank voor AI-systemen met een hoog risico

Met de verplichting voor aanbieders om AI-systemen met een hoog risico te registreren in een EU-databank, zorgt het Voorstel voor meer transparantie. De in die databank opgenomen informatie is vrij toegankelijk voor het publiek en moet gedurende de periode dat het AI-systeem in gebruik is, steeds worden geactualiseerd. Het gaat niet alleen om contactgegevens van de aanbieder en de handelsnaam waaronder het AI-systeem in de handel wordt gebracht, maar ook om onderdelen van de technische documentatie zoals de elektronische gebruiksaanwijzing. Ook een beschrijving van de beoogde doelen van het AI-systeem, de status (wel/niet in gebruik), het verstrekte certificaat of de EU-conformiteitsverklaring (inclusief een beschrijving van de uitgevoerde conformiteitsbeoordelingsprocedure) maken onderdeel uit van de informatie in de EU-databank. Een bedrijfsjurist kan bij de registratie door een aanbieder beoordelen of niet tevéél informatie wordt geregistreerd. In een conformiteitsbeoordelingsprocedure wordt, wanneer deze wordt uitgevoerd door de aangemelde instantie, soms zeer vertrouwelijke informatie gedeeld. Het Voorstel biedt in Bijlage VIII de aangemelde instantie uitdrukkelijk de mogelijkheid om broncodes en testverslagen op te vragen. De bedrijfsjurist kan de AI-functionaris ondersteunen bij het maken van de selectie van de documenten die in de EU-databank geregistreerd moeten worden. Gelukkig bevat het Voorstel wel bepalingen over de vertrouwelijkheid van door aanbieders verstrekte informatie. Er geldt een strenge geheimhoudingsverplichting voor bijvoorbeeld bedrijfsgeheimen en intellectuele eigendomsrechten.

Een maximale boete van wel 30 miljoen Euro!

Het Voorstel verplicht lidstaten om nationale voorschriften voor sancties vast te stellen. De bedragen voor de administratieve boete zijn flink hoger dan bijvoorbeeld die in de AVG worden genoemd. Bij het opleggen van sancties wordt wel rekening gehouden met de belangen van kleine aanbieders en startups en hun economische levensvatbaarheid. De boete voor het uitvoeren van verboden prakijken (artikel 5) kan oplopen tot wel 30 miljoen Euro (of, als de overtreder een onderneming is, tot 6% van haar totale wereldwijde jaarlijkse omzet voor het voorafgaande boekjaar, als dat hoger is). Voor kleine ondernemingen is dit percentage in een compromisvoorstel vastgesteld op 3%. Voor andere overtredingen is een boete van 20 miljoen Euro opgenomen of een percentage van 4% van de totale wereldwijde jaarlijkse omzet (voorafgaande boekjaar). Voor kleine ondernemingen is dit percentage vastgesteld op 2%. Een derde categorie boete is een boete van maximaal 10 miljoen Euro of 2% van de totale wereldwijde jaarlijkse omzet in geval van het verstrekken van onjuiste, incomplete of misleidende informatie aan de bevoegde autoriteiten (1% voor kleine ondernemingen

Compromisvoorstellen

In het Europees Parlement worden de discussies gevoerd onder leiding van twee commissies: Internal Market and Consumer Protection (IMCO) en Committee on Civil Liberties, Justice and Home Affairs (LIBE). Het conceptrapport van april 2022 van deze commissies heeft meer dan 3000 amendementen ontvangen. De stemming over dit rapport is gepland voor oktober 2022. De inhoud van dit rapport wordt in dit artikel niet besproken.

De Raad en het Europees Parlement komen dus dit najaar met hun standpunten. In het rapport van 15 juli 2022 van de Raad staan alvast een aantal belangrijke overwegingen om het Voorstel ingrijpend te gaan wijzigen. Zo noemt de Raad de definitie van AI-systeem. Voorgesteld wordt om de definitie te beperken tot systemen die zijn ontwikkeld door middel van machine learning technieken en logica- en kennisgebaseerde aanpakken. Door toe te voegen dat enige mate van autonomie is vereist, valt software die slechts een taak geautomatiseerd uitvoert zoals mensen dit stap voor stap hebben geprogrammeerd, buiten de scope van de definitie. Dit is een groot verschil met het oorspronkelijke Voorstel van de Commissie zoals hierboven uiteengezet.

Verder bespreekt de Raad de classificatie van AI-systemen met een hoog risico. Voorgesteld wordt om de reikwijdte te beperken ten op zichte van het Voorstel door middel van de introductie van een extra horizontale laag boven de AI-systemen met een hoog risico. In die extra laag is vereist dat het moet gaan om AI-systemen waarvan de output onmiddellijk invloed heeft zonder menselijke tussenkomst of AI-systemen waarvan de output de enige basis vormt voor de te nemen beslissing, die mogelijk een aanzienlijk risico vormt voor de gezondheid of veiligheid van personen of voor grondrechten. Verder zijn een viertal use cases uit bijlage III verwijderd, te weten (a) AI-systemen die gebruikt worden om emissies en vervuiling te beheersen, (b) AI-systemen voor bepaalde verzekeringstoepassingen, (c) een aantal AI-systemen voor opsporingsdiensten en (d) AI-systemen die gebruikt worden voor echtheidcontroles van reisdocumenten. Deze AI-systemen worden dus niet langer gekwalificeerd als AI-systemen met een hoog risico.

De Raad heeft ook een aanvulling voorgesteld over het onderwerp toezicht en handhaving. Een aantal landen vreesde een onvoldoende kennisniveau bij nationale autoriteiten. De voorgestelde oplossing daarvoor bestaat uit een tweetal componenten: (i) de positie van de European AI Board wordt verstevigd, zodat die de lidstaten beter kan ondersteunen bij de implementatie. Men heeft zich hier laten inspireren door de recent geïnstalleerde European Data Innovation Board (Data Governance Act) en (ii) er zijn twee nieuwe artikelen geïntroduceerd (68a en 68b). Op grond van deze nieuwe artikelen wordt het mogelijk dat de European AI Board onafhankelijk technisch of wetenschappelijk advies aan een test facility kan vragen en er wordt een pool van onafhankelijke experts die implementatieactiviteiten kunnen ondersteunen samengesteld.

General Purpose AI-systemen

Anders dan het in het eerste compromise proposal voorgestelde artikel 52a, waarin General Purpose AI-systemen (dit zijn AI-systemen die een algemeen toepasbare functie hebben, zoals bijvoorbeeld stemherkenningssoftware) waarschijnlijk op aangeven van de grote technologiebedrijven compleet buiten het toepassingsbereik van het Voorstel werden geplaatst, bevat het document van de Raad van 15 juli 2022 verder een voorstel (artikel 4b) waarin er wel degelijk verplichtingen worden opgelegd aan de aanbieders van General Purpose AI-systemen en vereisten worden gesteld aan de betreffende AI-systemen. Naast dit artikel 4b is een nieuwe overweging 12aa toegevoegd. Artikel 4b zal niet van toepassing zijn op kleine ondernemingen. Het uitgangspunt is dus dat eenieder in de keten de verantwoordelijkheid draagt die hij kan dragen en dat samenwerking om de regelgeving na te leven verplicht is gesteld (artikel 4b lid 5). Nadat de Commissie General Purpose AI-systemen volledig onder het Voorstel lieten vallen en het Sloveense voorzitterschap ze juist geheel uitsloot is nu een gulden middenweg gekozen.

Het hiervoor kort besproken artikel 28 van het Voorstel, dat van een gebruiker soms ook ineens een aanbieder maakte, is ook aangepast en is nu opgenomen als artikel 23a. Lid 2 van dat artikel zorgt ervoor dat de oorspronkelijke aanbieder niet meer als zodanig wordt gezien wanneer een gebruiker zijn rol overneemt door het product bijvoorbeeld onder zijn naam op de markt te brengen. Een interessante vraag is hoe de aansprakelijkheid in de verschillende lidstaten is geregeld wanneer een onderneming het product tegelijkertijd in meerdere landen op de markt brengt en er geconstateerd wordt dat aan een bepaling van de AI Act met verplichtingen van aanbieders niet wordt voldaan. Zo is onder meer de vraag of de oorspronkelijke aanbieder dan niet meer kan worden aangesproken.

Ten slotte heeft de Raad nog aandacht besteed aan de bewaarplicht (daarvoor is een termijn van tien jaar voorgesteld), aan wetenschappelijk onderzoek (valt niet meer in de scope), aan in hoeverre het Voorstel van toepassing is op zaken van nationale veiligheid en aan de oprichting van een EU-databank. De Raad stelt voor artikel 60 van het Voorstel zodanig aan te passen dat meer informatie moet worden geregistreerd in de EU-databank, maar dat een deel van die informatie niet openbaar toegankelijk is. Het gaat dan bijvoorbeeld over informatie inzake testomgevingen in de echte wereld buiten zogenoemde regulatory sandboxes. Die informatie is dan uitsluitend beschikbaar voor bevoegde autoriteiten.

De Europese Commissie krijgt nadat door de Raad en het Europees Parlement overeenstemming is bereikt over alle aanpassingen en amendementen nog de gelegenheid om met een advies te reageren op de voorgestelde aanpassingen.

Regulatory sandbox

Eind juni 2022 is een eerste pilot genaamd regulatory sandbox gepresenteerd. De bedoeling van deze pilot is het samenbrengen van bevoegde autoriteiten en ontwikkelaars van AI-systemen om best practices te ontwikkelen voor de implementatie van de uiteindelijke AI-verordening. Men hoopt op deze manier ervoor te zorgen dat de implementatie door de nationale autoriteiten binnen twee jaar zal plaatsvinden. Vanaf oktober 2022 gaat de pilot van start. De resultaten worden gepubliceerd tijdens het Spaanse EU-voorzitterschap in 2023. De opgedane ervaringen worden gedeeld in de vorm van best practices en implementatierichtlijnen.

Regulatory sandboxes komen ook voor ín het Voorstel (artikel 53 e.v.). In het document van 15 juli 2022 van het Tsjechische voorzitterschap wordt onder regulatory sandbox een gecontroleerde omgeving verstaan waarbinnen een aanbieder AI-systemen op basis van een plan voor een beperkte duur kan ontwikkelen, trainen, valideren en testen onder supervisie van de toezichthouder. Kleine aanbieders krijgen voorrang tot de AI-testomgevingen als zij aan bepaalde voorwaarden voldoen.

Voorbereiden op de AI Act

Bedrijfsjuristen doen er hun voordeel mee om hun ondernemingen te adviseren om nu al voorbereidingen te treffen, al is het Voorstel nog niet definitief. Wat al opgezet kan worden is een register, waarin alle AI-systemen die gebruikt worden of ontwikkeld worden, staan vermeld. Kenmerken als datum ingebruikname, welke inputdata is gebruikt, doel van het gebruik, logs, bewaartermijnen, parameters en classificatie (risicoanalyse) kunnen alvast in beeld worden gebracht.

Bedrijfsjuristen in internationale concerns zullen niet alleen te maken krijgen met Europese regelgeving over AI, maar ook met het regelgevend kader van andere landen. Het Verenigd Koninkrijk bijvoorbeeld heeft op 18 juli 2022 het National AI Strategy – AI Action Plan en een AI Paper gepubliceerd. De voorstellen voor een nieuwe AI Rulebook gaan uit van zes kernprincipes die de sectorale toezichthouders toe moeten passen. De zes kernprincipes zijn geformuleerd als volgt: (a) zorgen dat AI veilig wordt gebruikt; (b) zorgen dat AI technisch veilig is en functioneert zoals het ontworpen is; (c) AI moet transparant en uitlegbaar zijn; (d) rechtvaardigheid; (e) een (rechts)persoon draagt de verantwoordelijkheid voor AI; (f) er is een loket voor de betwisting van resultaten en het verhalen van schade. Op de voorstellen voor regelgeving kan nog commentaar worden gegeven[xi]. Het kan behoorlijk wat werk voor de bedrijfsjurist worden om op de hoogte te blijven van de verschillende wetgevingsinitiatieven en de voortgang daarvan.

Ten slotte

Met het Voorstel voor een AI Act komt een uitgebreid regelgevend kader op ons allen af. Het is vanwege de vele wijzigingsvoorstellen nog even afwachten hoe het uiteindelijke Voorstel eruit zal gaan zien. In het najaar weten we hopelijk meer. Met name vanwege hun morele kompas en vaardigheden op het gebied van risicoanalyse en risico-mitigering kunnen bedrijfsjuristen de onderneming waar zij werken ondersteunen bij de implementatie van de AI Act. De bedrijfsjurist kan de (vrijwillige) gedragscode voor AI-systemen met een laag risico opstellen, assisteren bij de registratie in de EU-databank van AI-systemen met een hoog risico en bij het uitvoeren van de beoordelingen die gedurende de levensduur van AI-systemen met een hoog risico moeten worden uitgevoerd en bijdragen aan de ethische beoordelingen van de voorgenomen toepassingen van AI-systemen. Zoals het Voorstel er op dit moment uit ziet, krijgt de bedrijfsjurist genoeg te doen!

Dit is het zevende artikel namens de NGB Werkgroep Digitalisering. Eerder verschenen de artikelen:

- Cloud & SaaS contracten

- Gebruik van Open Source Software

- Risicobeperking bij contracteren met startups

- Gebruik van elektronische handtekeningen

- NIS2-richtlijn en Cybersecurity

- USA Cloud Services and products

[i] https://www.gsb.stanford.edu/insights/andrew-ng-why-ai-new-electricity

[ii] https://wibnet.nl/techniek/kunstmatige-intelligentie/ai-in-oorlog-killerdrones-nemen-het-slagveld-in

[iii] https://www.nrc.nl/nieuws/2022/06/25/burgemeester-berlijn-voert-half-uur-gesprek-met-deepfake-klitsjko-a4134666

[iv] https://ecp.nl/wp-content/uploads/2018/11/Artificial-Intelligence-Impact-Assesment.pdf

[v] https://eur-lex.europa.eu/legal-content/NL/TXT/HTML/?uri=CELEX:52021PC0206&from=EN Wet op de artificiële intelligentie, 2021/0106.

[vi] Zie de toelichting bij het voorstel, onder het kopje “Motivering en doel van het voorstel” (Voorstel voor een Verordening van het Europees Parlement en de Raad tot vaststelling van geharmoniseerde regels betreffende artificiële intelligentie (wet op de artificiële intelligentie) en tot wijziging van bepaalde wetgevingshandelingen van de unie {SEC(2021) 167 final} - {SWD(2021) 84 final} - {SWD(2021) 85 final}, met kenmerk 2021/0106 COD).

[vii] [Webinar]

[viii] https://www.pwc.nl/nl/actueel-en-publicaties/themas/digitalisering/europese-ai-verordening-veel-procedurele-en-inhoudelijke-eisen.html

[ix] Tijdens de Telecomraad van 3 juni 2022 heeft Nederland aandacht gevraagd voor de impact van de AI Act op het MKB. Het vraagt een behoorlijke inspanning van het MKB om aan alle (nieuwe) Europese regelgeving te voldoen.

[x] In de IT-sector bestaat al een voorbeeld van een gedragscode: de ethische gedragscode artificial intelligence van NLDigital.

[xi] https://www.gov.uk/government/news/uk-sets-out-proposals-for-new-ai-rulebook-to-unleash-innovation-and-boost-public-trust-in-the-technology

Bron afbeelding: https://digital-strategy.ec.europa.eu/en/policies/regulatory-framework-ai

iNHOUDSOPGAVE